Холиварофорум

Вы не вошли.

#2401 2025-07-05 16:19:34

- Анон

Re: Восстание машин: ИИ против человека

Типа, ну это же для души, это искусство, ну как так-то

А ты бы хотел, чтобы кто-то, написав фик, пошел к художнику, который бы потребовал от него минимум 5к рублей, делал бы заказ месяц, отговариваясь разными причинами, а потом выдал бы что-то кривое? Писателю фанфиков проще бесплатно сгенерировать это кривое.

#2402 2025-07-05 16:53:33

- Анон

Re: Восстание машин: ИИ против человека

Почему фики это тебе сразу секс фантазии?

Я про пост с реддита

#2403 2025-07-05 17:15:16

- Анон

Re: Восстание машин: ИИ против человека

А ты бы хотел, чтобы кто-то, написав фик, пошел к художнику, который бы потребовал от него минимум 5к рублей, делал бы заказ месяц, отговариваясь разными причинами, а потом выдал бы что-то кривое?

Я так понимаю, он бы хотел, чтобы если ты не умеешь рисовать или не можешь себе позволить, выставлял бы свой фик без обложки и дал посиять тем, кто в состоянии.

#2404 2025-07-05 18:46:13

- Анон

Re: Восстание машин: ИИ против человека

Продолжая более ранюю идею про обложки

Отредактировано (2025-07-05 18:46:54)

#2405 2025-07-06 12:13:31

- Анон

Re: Восстание машин: ИИ против человека

Забавное видео из шоу Джона Оливера про то, что генеративные ИИ = спам

John Oliver explains why you’ve been seeing more AI-generated content online

#2406 2025-07-06 12:24:16

- Анон

Re: Восстание машин: ИИ против человека

Это было статусной штукой, иметь "хороший" арт, потому что это означало что ты либо кому-то понравился настолько, что он угрохал 10+ часов жизни на то чтобы проиллюстрировать твою идею, или сам так любишь этот фик, что вгрохал денег на хорошего артера. Это давало повод у обложек, которые выглядят посложнее, остановится и приглянуться к фику.

Это скорее показатель того, что райтер имеет некоторое количество лишних денег. Вспоминается сразу нетленка Аши, которую давным-давно читали, которая говно говном по качеству, но иллюстрации есть и вроде неплохие

#2407 2025-07-06 12:51:56

- Анон

Re: Восстание машин: ИИ против человека

Это скорее показатель того, что райтер имеет некоторое количество лишних денег.

+100500

обложки говорили скорее о чсв автора, а не о качестве его работ

#2408 2025-07-09 13:09:28

- Анон

Re: Восстание машин: ИИ против человека

Внесу пожалуй веселую (ну или не очень) историю о том, как Грок научился у Твиттера плохому. https://www.theatlantic.com/technology/ … ts/683463/

Анон помнит байку из студенчества про другую нейронку, попорченную Твиттером (что характерно). Ее быстро отключили https://www.google.com/amp/s/www.cbsnew … cist-nazi/

#2409 2025-07-10 17:30:53

- Анон

Re: Восстание машин: ИИ против человека

Ютьюб собирается срезать монетизацию у ИИвидосов:

https://techcrunch.com/2025/07/09/youtu … lop-grows/

#2410 2025-07-10 18:25:37

- Анон

Re: Восстание машин: ИИ против человека

Ютьюб собирается срезать монетизацию у ИИвидосов:

Вот кстати насчет Ютюба, что я бы очень хотел в плане ИИ увидеть от них - нормальное распознавание голоса и авто-перевод на все языки. У них это типа "есть", но по факту там явно уровень пятилетней давности, то есть каменный век при современном скачке развития ИИ. В очень многих видео плохо распознает язык, что для английского, что для русского, не говоря уже о более экзотических, причем не умеет понимать контекст, а вместо этого распознает по одному слову - соответственно, получается полная чушь зачастую. А уж с учетом современных ИИ, которые могли бы контекст еще и по картинке понимать - можно было бы вообще делать 99.99% понимание. И мы могли бы смотреть дорамы на любых языках

#2411 2025-07-10 19:36:50

- Анон

Re: Восстание машин: ИИ против человека

В очень многих видео плохо распознает язык, что для английского, что для русского, не говоря уже о более экзотических, причем не умеет понимать контекст, а вместо этого распознает по одному слову

Видео азиатских крафтеров это боль

#2412 2025-07-10 20:05:48

- Анон

Re: Восстание машин: ИИ против человека

Вот кстати насчет Ютюба, что я бы очень хотел в плане ИИ увидеть от них - нормальное распознавание голоса и авто-перевод на все языки.

У них очень плохой перевод в принципе. Там же используется гуглтранслейт, который ужасен.

#2413 2025-07-10 20:09:36

- Анон

Re: Восстание машин: ИИ против человека

с учетом современных ИИ, которые могли бы контекст еще и по картинке понимать

А как ты предлагаешь это встраивать в видео? На каждый фрейм точно нет, пиздец дорого.

#2414 2025-07-10 20:49:07

- Анон

Re: Восстание машин: ИИ против человека

В очень многих видео плохо распознает язык, что для английского, что для русского, не говоря уже о более экзотических, причем не умеет понимать контекст, а вместо этого распознает по одному слову - соответственно, получается полная чушь зачастую

Когда зеркальная галерея превращается в галерею мороженого:) Смотрю французские документалки в яндексовском автодубе:)

#2415 2025-07-10 21:09:07

- Анон

Re: Восстание машин: ИИ против человека

Когда зеркальная галерея превращается в галерею мороженого:) Смотрю французские документалки в яндексовском автодубе:)

Зато тренируешь логическое мышление и активно ищешь причинно-следственные связи  А то совсем со своим ИИ отупеть собрались

А то совсем со своим ИИ отупеть собрались

#2416 2025-07-11 00:31:01

- Анон

Re: Восстание машин: ИИ против человека

На каждый фрейм точно нет, пиздец дорого

Зачем каждый фрейм-то? В 99% случаев распознается и без этого. В 99% случаев от оставшегося контекст не скачет в течение видео - можно взять фрейм и посмотреть, условно, про лыжи там или про LG.

#2417 2025-07-11 00:48:32

- Анон

Re: Восстание машин: ИИ против человека

У них это типа "есть", но по факту там явно уровень пятилетней давности, то есть каменный век при современном скачке развития ИИ.

Анон, это нормально для переводчиков. ГПТ тяжелая модель, реалтайм с ней не заведешь. Что касается качества, сомневаюсь, что оно лучше, чем у более простых, но заточенных чисто под перевод моделей.

причем не умеет понимать контекст, а вместо этого распознает по одному слову - соответственно, получается полная чушь зачастую. А уж с учетом современных ИИ, которые могли бы контекст еще и по картинке понимать - можно было бы вообще делать 99.99% понимание. И мы могли бы смотреть дорамы на любых языках

Трансформеры, на которых построен гугл-транслейт технически умеют работать с контекстом. Они для этого создавались: чтобы информация о токенах распространялась интенсивнее.

О переводчике с картинкой-контекстом анон не слышал, ибо применение гипотетически очень узкое. Для перевода дорамы нужен скорее переводчик по видеоряду+тексту, который непонятно зачем нужен. Лучше скилованного кожаного переводчика он не сделает, а перевод чисто по словам будет достаточно хорош, чтобы понимать, что происходит. Так что нет, современные ИИ так не умеют и скорее всего не будут уметь.

Пара слов про перевод. Если у тебя нет достаточного количества пар текстов русский-китайский, то тебе не пизда: тут будет работать перевод через английский. По личному опыту, бытовые фразы он переводит хорошо. Но если тебе надо перевести беларусский-грузинский (условно), будет хуже, потому что здесь текстов с переводом на английский будет более грустное количество.

#2418 2025-07-11 01:03:12

- Анон

Re: Восстание машин: ИИ против человека

Зачем каждый фрейм-то? В 99% случаев распознается и без этого. В 99% случаев от оставшегося контекст не скачет в течение видео - можно взять фрейм и посмотреть, условно, про лыжи там или про LG.

А если на фотке реклама телека LG с картинкой лыжника?

Есть одна проблема: машина не понимает, хорошо она перевела или нет в режиме инференса. Распознаватель речи не обучают выдавать ещё достаточность контекста. А ещё фрейма для художественного фильма недостаточно по причине, называемой монтаж

#2419 2025-07-11 01:09:43

- Анон

Re: Восстание машин: ИИ против человека

нормально для переводчиков. ГПТ тяжелая модель, реалтайм с ней не заведешь

Ну не знаю, если говорить именно о переводе текста, то если я бросаю в ГПТ файл, он хуярит перевод с такой скоростью, что у человека займет двадцать минут все это произнести.

Что касается качества, сомневаюсь, что оно лучше, чем у более простых, но заточенных чисто под перевод моделей.

Ну уж получше, чем у гуглтранслейта.

Но в целом, основная проблема в ютюбовском переводе - распознавание, по-моему. Я когда включаю (точнее не выключаю) субтитры к видео на русском, там же ужас, там буквально половина слов мимо, не говоря уже о том, что все это идет по одному слову:

конь... стул... двадцать вышел...

экскременты... статоры...

Понятно, что такое ни один переводчик нормально не переведет, включая кожаных.

#2420 2025-07-11 01:58:12

- Анон

Re: Восстание машин: ИИ против человека

нормально для переводчиков.

Ты будешь опровергать, что гуглтранслейт застрял во времени на пять лет назад? А они до сих пор не почесались улучшить алгоритмы.

Отредактировано (2025-07-11 01:58:33)

#2421 2025-07-12 19:32:41

- Анон

Re: Восстание машин: ИИ против человека

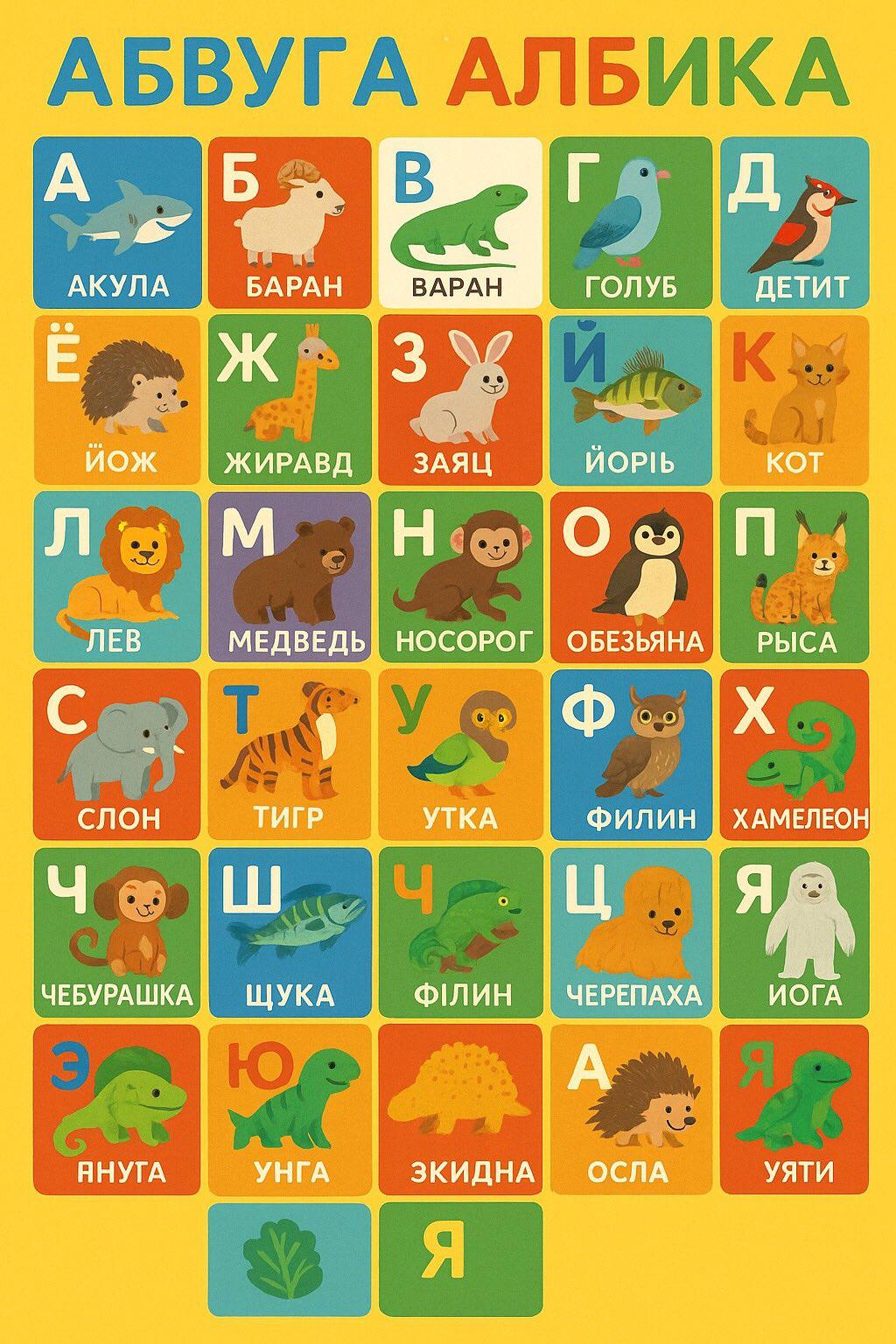

Подборка всратых ии азбук

в посте и комментариях тут: https://illustrators.ru/posts/smeshnye- … -neyroseti

#2422 2025-07-12 19:35:57

- Анон

Re: Восстание машин: ИИ против человека

Мне нравятся ЙОРIЬ, ЧЕРЕПАХА И ИОГА! ЗКИДНА тоже ок

#2423 2025-07-12 19:40:40

- Анон

Re: Восстание машин: ИИ против человека

Детит и Уяти

#2424 2025-07-12 21:16:44

- Анон

Re: Восстание машин: ИИ против человека

Мне нравится, как там постепенно ненавязчиво появился йети, которого в следующей же азбучке подписали как Йога

#2425 2025-07-13 08:16:42

- Анон

Re: Восстание машин: ИИ против человека

Подборка всратых ии азбук

спасибо, анон